Tensorflow 시작하기 9 (성능 향상-학습 반복량 증가)

사용 버전: Python 3.7.6, Tensorflow 2.1.0

이번 시간에는 간단한 방법으로 성능을 향상시키는 방법에 대해서 알아보겠습니다.

아래는 성능 향상하기 전 그래프입니다.

학습 반복량(epoch)을 조절해보겠습니다.

epoch를 5에서 23으로 증가했습니다.

맞던 3 도 안 맞게 되었습니다.

epoch를 50으로 증가해보겠습니다.

3과 5를 맞췄네요. 조금 괜찮아졌네요.

3과 5를 맞췄네요. 조금 괜찮아졌네요.

한 번 200 번 반복해보겠습니다.

3과 5의 확률이 더 높아졌네요.

만약 학습 데이터의 loss, accuracy가 test의 loss, accuracy와 차이가 많이 난다면, 과적합(overfitting)을 의심해봐야 합니다.

계속 성능 향상을 진행하겠습니다.

끝.

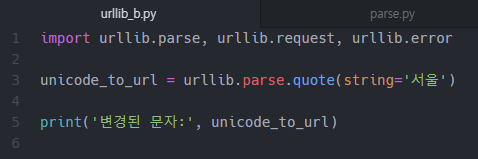

코드:

https://github.com/shwoghk14/mnist_tensorflow

기획: MNIST 데이터 셋을 이용하여, 손글씨 숫자를 맞추는 AI(인공지능) 만들기

이번 시간에는 간단한 방법으로 성능을 향상시키는 방법에 대해서 알아보겠습니다.

아래는 성능 향상하기 전 그래프입니다.

학습 반복량(epoch)을 조절해보겠습니다.

epoch를 5에서 23으로 증가했습니다.

맞던 3 도 안 맞게 되었습니다.

epoch를 50으로 증가해보겠습니다.

3과 5를 맞췄네요. 조금 괜찮아졌네요.

3과 5를 맞췄네요. 조금 괜찮아졌네요.한 번 200 번 반복해보겠습니다.

3과 5의 확률이 더 높아졌네요.

만약 학습 데이터의 loss, accuracy가 test의 loss, accuracy와 차이가 많이 난다면, 과적합(overfitting)을 의심해봐야 합니다.

계속 성능 향상을 진행하겠습니다.

끝.

코드:

https://github.com/shwoghk14/mnist_tensorflow

카테고리: Tensorflow, BlackSmith

댓글

댓글 쓰기

궁금한 점은 댓글 달아주세요.

Comment if you have any questions.